[RedHat][vLLM]

人工智能的主要算力都是用在推理(Inference)方面,如何降低推理成本和提高推理效率,一直是業界最關心AI問題。

vLLM(Virtual Large Language Model)是加大柏克萊分校 2023 年開發LLM大語言模型推理框架並開源, 提供高輸送量的LLM推理並大大降低GPU記憶用量,迅速成為最受關注的開源項目。 Continue reading “Red Hat推出推理服務器 vLLM普及AI成本下降”

[RedHat][vLLM]

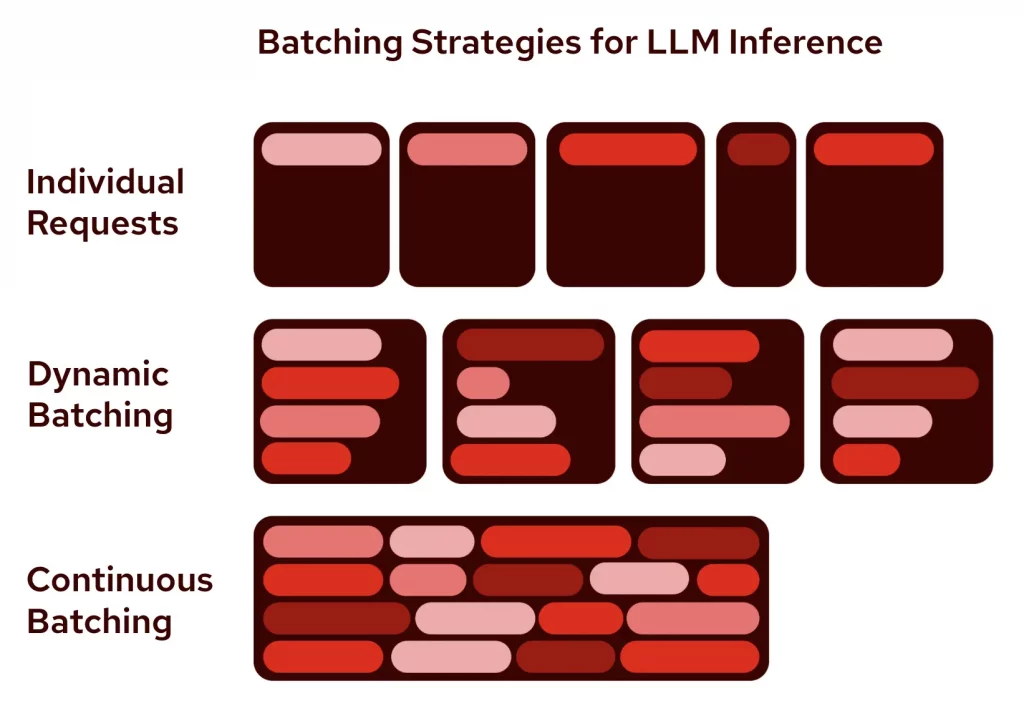

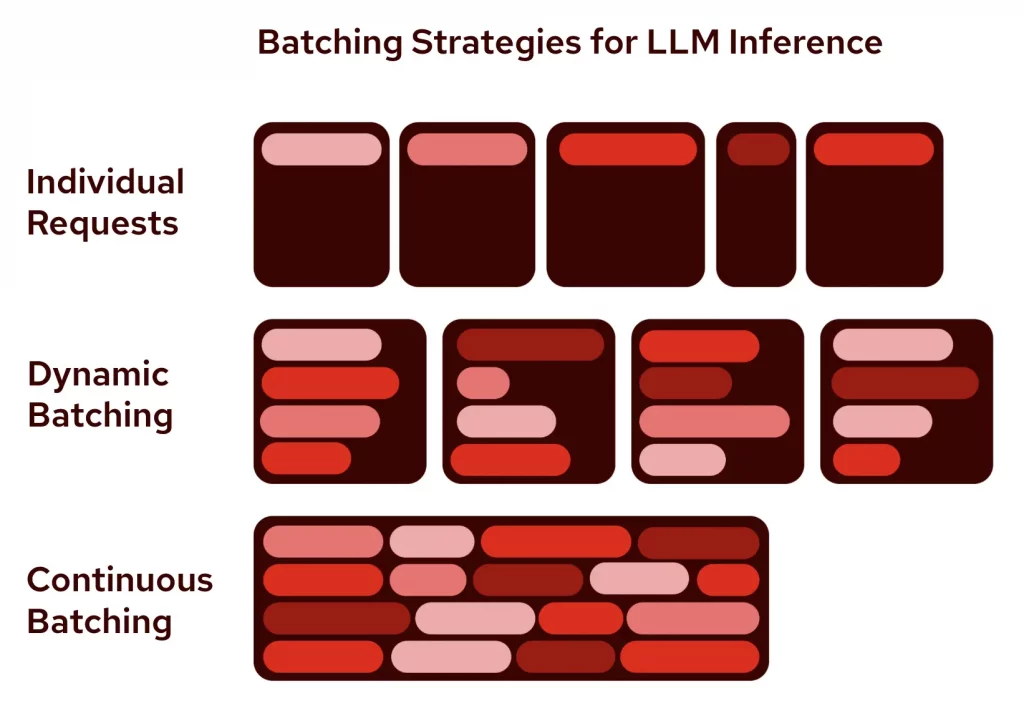

人工智能的主要算力都是用在推理(Inference)方面,如何降低推理成本和提高推理效率,一直是業界最關心AI問題。

vLLM(Virtual Large Language Model)是加大柏克萊分校 2023 年開發LLM大語言模型推理框架並開源, 提供高輸送量的LLM推理並大大降低GPU記憶用量,迅速成為最受關注的開源項目。 Continue reading “Red Hat推出推理服務器 vLLM普及AI成本下降”

[Alibaba]

阿里巴巴集團發佈開源大語言模型家族最新混合推理模型Qwen3,,融合了傳統大語言模型(LLM)與專家混合(MoE)技術。 Continue reading “Alibaba| Qwen3學術及多語言出色 開源有助中國AI全球競爭”

[企業轉型]

國內多家公有雲接入DeepSeek,利用Agent建立應用和知識庫,商湯提供DeepSeek推理和定制外,再推出開源Agent平台,以加快建立應用。

商湯大裝置萬象平台已提供DeepSeek-R1和DeepSeek-V3模型,免費版提供3個月內千萬Token,再正式推出企業版,完成免費版國產化適配與擴大算力容量。 Continue reading “企業轉型| 推低代碼多Agent平台 商湯助企業建AI應用”

[新科技速遞]

生成式AI應用處於爆發期,香港企業利用生成式AI,卻仍有不少障礙。IBM總結不少經驗,透過建立合作關係,加上新一代小巧LLM語言模型,加快生成式AI落地。 Continue reading “新科技速遞| 簡化生成式AI本地部署 IBM夥拍OneAsia拓市場”